Je denkt dat chatbots nieuw zijn

De meeste gesprekken over AI beginnen met dezelfde overtuiging: nu is alles anders. ChatGPT veranderde alles. Vroeger waren chatbots dom. Nu zijn ze eindelijk slim.

Dat klinkt logisch. En precies daarom is het gevaarlijk.

Want als chatbots nu pas bruikbaar zijn, waarom vertrouwen banken, vliegtuigmaatschappijen en ziekenhuizen dan al jaren op systemen die niet klinken als mensen?

Welke chatbot zou jij vertrouwen?

Stel je krijgt drie antwoorden op dezelfde vraag. Eén klinkt vriendelijk en menselijk. Eén is kort, zakelijk en beperkt. Eén stelt vooral wedervragen.

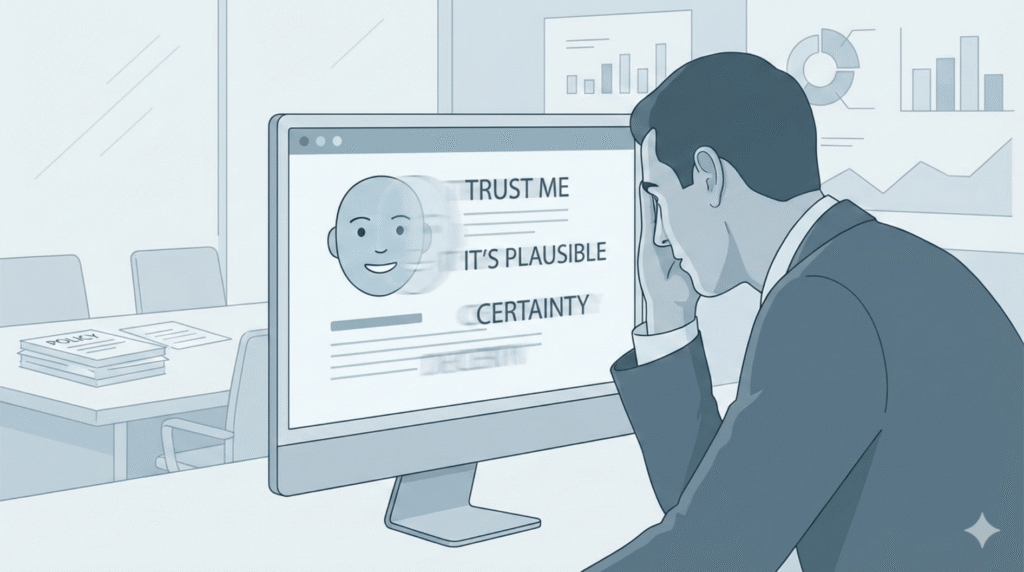

De meeste mensen kiezen de chatbot die het beste klinkt. Niet degene die controleerbaar is. Niet degene die veilig faalt. Maar degene die zelfverzekerd praat.

Dat voelt rationeel. Tot je je dit afvraagt: wat als goed klinken precies is wat een fout onzichtbaar maakt?

Chatbots bestonden al lang voordat ze slim klonken

Lang voordat iemand het woord GenAI gebruikte, waren chatbots er al. Niet omdat ze taal begrepen, maar omdat ze dat niet hoefden.

Gescripte chatbots bleven binnen hun grenzen. Ze volgden vooraf bepaalde paden. Ze reageerden alleen op wat expliciet was toegestaan. En ze faalden veilig: door niets te doen of nee te zeggen.

Dat voelde frustrerend (understatement :-)) Maar het was ook veilig(er).

GenAI lost geen oud probleem op

Met grote taalmodellen gebeurde iets fundamenteel anders. Niet: de chatbot weet nu meer. Maar: de chatbot kan nu alles laten klinken alsof hij het weet.

Dat verschil is niet subtiel. Een gescripte bot kan alleen fouten maken die je ziet. Een GenAI-chatbot kan fouten maken die perfect aansluiten bij je verwachtingen.

Hij speelt geen waarheids-spel. Hij speelt een waarschijnlijkheids-spel.

“Maar ik merk heus wel wanneer een chatbot fout zit”

Bijna iedereen overschat zichzelf hier. Want wat je eigenlijk zegt is: ik herken fouten zolang ik het juiste antwoord al ken.

De gevaarlijkste fouten zijn niet de domme. Het zijn de plausibele. De fouten die grammaticaal kloppen, logisch klinken en jouw denkpatroon bevestigen.

De beste chatbot bestaat niet

Vraag tien mensen naar de beste chatbot en je krijgt lijstjes. Maar beste voor wat? Voor creativiteit? Voor samenvatten? Voor beslissingen met gevolgen?

Dit zie je vooral bij organisaties die AI inzetten voor beleid, HR of klantcontact. Daar wordt een chatbot al snel meer dan een schrijfhulp.

Een chatbot is geen universeel hulpmiddel. Het is een context-machine.

De juiste vraag is niet welke chatbot het beste is, maar waar je hem niet voor durft te gebruiken en waarom. Als je die afbakening niet kunt maken, gebruik je hem te breed.

Prompten is geen vragen stellen

Je denkt dat je communiceert. In werkelijkheid ontwerp je omstandigheden.

Dat verklaart ook waarom teams die AI inzetten voor besluitvorming vaak verschillende uitkomsten krijgen op dezelfde vraag. Niet omdat het model wispelturig is, maar omdat de context verschilt.

Wanneer je een rol toewijst, grenzen stelt en voorbeelden geeft, vraag je geen kennis op. Je stuurt gedrag.

Je praat niet met een denker. Je programmeert (vaak onbewust) een reactie-ruimte.

Veiligheid, GDPR en duurzaamheid komen altijd te laat

Dit gaat bijna altijd mis bij organisaties die AI “even proberen” zonder vooraf te bepalen waarvoor het níét bedoeld is.

Niet omdat de regels onduidelijk zijn, maar omdat veiligheid wordt gezien als een technisch probleem. In werkelijkheid is het een gedragsprobleem.

De grootste risico’s ontstaan niet doordat chatbots iets kunnen, maar doordat mensen te veel vertrouwen, te weinig afbakenen en geen onderscheid maken tussen denken, schrijven en beslissen.

Wat je moet onthouden

Hoe menselijker een chatbot klinkt, hoe belangrijker het wordt om hem niet automatisch te vertrouwen.

Plausibele antwoorden voelen veilig, maar maken fouten juist moeilijker te herkennen — vooral in situaties waarin beslissingen gevolgen hebben voor mensen, beleid of geld.

De echte vaardigheid is daarom niet beter prompten, maar bewuster kiezen wanneer je een antwoord níét zou moeten willen.

Niet elke vraag verdient een antwoord van een chatbot. Dat inzicht maakt het verschil tussen slim gebruik en blind vertrouwen.

AI inzetten zonder jezelf voor de gek te houden

Eenvoudig.ai helpt teams bepalen waar AI ondersteunt — en waar menselijk oordeel onmisbaar blijft.